Sommaire

1/ Explications du contexte SEO Рgoogle a-t-il d̩sindex̩ mes urls ?

2/ Préparer ma liste d’urls avec R

3/ Utiliser Screaming Frog pour savoir si Google a désindexé mes urls

1/ Explications du contexte SEO Рgoogle a-t-il d̩sindex̩ mes urls ?

Dans l’outil bien connu des SEO qu’est la Search Console, un onglet des plus utiles existe nommé sobrement « Couverture ».

Il fait partie de la catégorie Index des outils de la search console vous le trouverez très simplement dans le menu. D’autres conseil sur le référencement naturel et le seo avec l’agence Newakey.

Lorsque vous cliquez, L’onglet s’affiche dans la partie droite de votre écran, si vous scrollez vers le bas vers la partie détails, vous aurez notamment la ligne « URL envoyée désignée comme noindex » cliquable.

Qu’est ce que URL envoyée désignée comme noindex signifie ?

C’est que Google a détecté sur votre site des pages avec la balise suivante

<meta name= »robots » content= »NOINDEX,NOFOLLOW,NOARCHIVE,NOODP » />

Avec cette balise html, vous indiquez à Google qu’il peut oublier purement et simplement cette page. C’est pour cette raison que l’on constate des erreurs : il explore des pages où on lui a interdit d’aller via une balise spécifique .

C’est par exemple ce que vous pouvez souhaiter faire pour un produit hors stock depuis longtemps dont vous ne voulez plus du tout sur votre site.

Or, Google n’en fait qu’a sa tête et va parfois crawler ces pages sans grand intérêt suite à quoi il renvoie une erreur dans la search console.

La solution la plus « simpliste » serait de désactiver la page en question et donc d’exporter cette liste en excel et de désactiver une à une les pages.

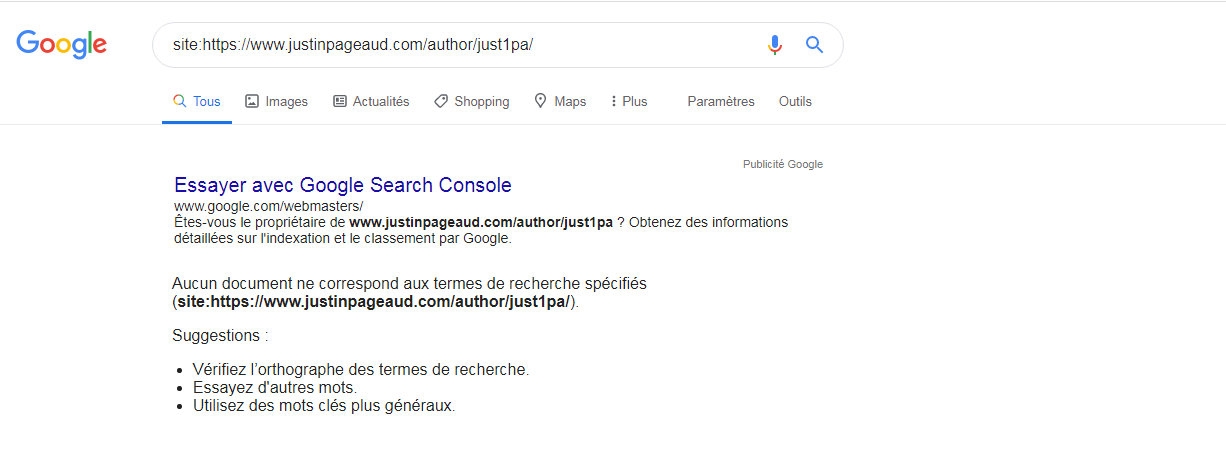

Cependant, il existe un écueil à cette méthode, en effet, les pages sorties en erreur dans la search console sont des fois encore dans l’index de google. Pour le vérifier, il suffit d’ajouter la commande site: avant l’url que vous souhaitez contrôler. Là dans le cas de ce site, il s’agit de l’url https://www.justinpageaud.com/author/just1pa/ qui est en erreur.Donc, il suffit de faire

site:https://www.justinpageaud.com/author/just1pa/

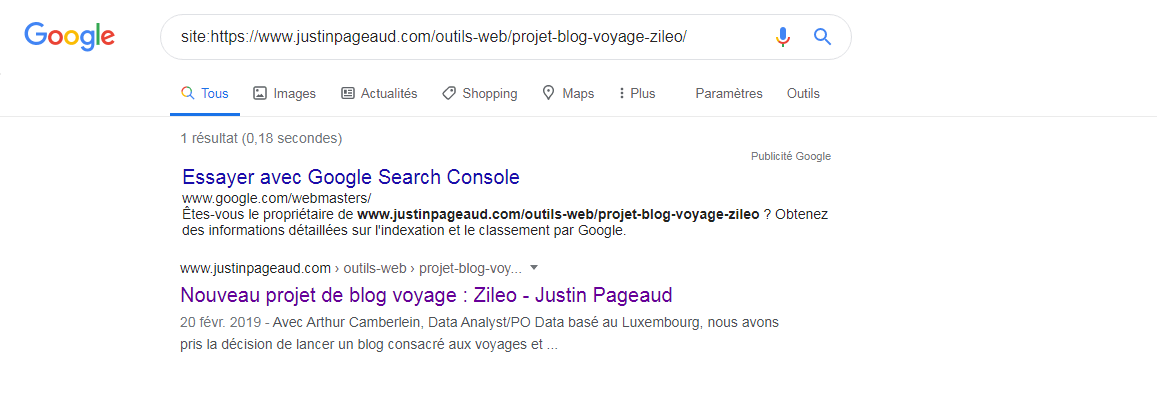

Dans ce cas précis, l’url en question a été oubliée par google, donc je peux sans problème la supprimer complètement de mon site internet. Google ne sera pas censé la crawler, Or il arrive assez souvent qu’une url en erreur soit encore présente dans l’index, ce qui donne un résultat de ce genre :

C’est embêtant parce que la page est encore dans l’index et la supprimer peut être susceptible de générer de futures 404, lorsqu’un internaute trouvera cette page lors de sa recherche Google .

La solution est donc de vérifier une à une les pages en erreur de la search console et de vérifier qu’elles soient bien désindexées … mais c’est fastidieux.

==> C’est pourquoi je vous partage une solution avec R et Screaming Frog permettant de savoir si une page est bien désindexée par Google .

2/ Préparer ma liste d’urls avec R

Bien sûr c’est également faisable en excel 😉

Pour installer R je vous conseille cet excellent article de Rémi Bacha.

Récupérez la liste en format xlsx via la search console, nommez la desindexation.xlsx et placez-la dans votre dossier R ( pour le choisir « setwd() » puis pressez entrer dans l’outil). Lancez L’application R studio et copiez-collez le code suivant :

# Réalisé par Justin Pageaud – Préparer la liste d’urls pour crawl Screaming Frog

list.of.packages <- « readxl »new.packages <- list.of.packages[!(list.of.packages %in% installed.packages()[, »Package »])]

if(length(new.packages)) install.packages(new.packages)library(readxl)

#1 Se mettre dans le bon dossier si besoin ( le chemin est séparé par /)

#setwd(« »)# 2. Récupérer le fichier source en xlsx

Fichier_xls <- read_excel(« desindexation.xlsx », sheet = 2)

for (i in 1:length(Fichier_xls$URL)) {

url<-Fichier_xls$URL

commande<-« site: »

urlfinie<-paste(commande,url,sep= » »)

urlfinie_recherche <- paste(« https://www.google.com/search?q= »,urlfinie,sep= »%20″)

df <- data.frame(urls=c(urlfinie_recherche), stringsAsFactors = F)

}# 3.Créer le csv

write.csv(x = df, file = « desindexationsf.csv »)

Après exécution de ce code, vous aurez à votre disposition un fichier nommé desindexationsf.csv.

Pour info, s’il y a une erreur, elle se situe à la ligne setwd(), vous devez enlever le # et mettre le dossier où se trouve réellement votre fichier desindexation.xlsx

3/ Utiliser Screaming Frog pour savoir si Google a désindexé mes urls

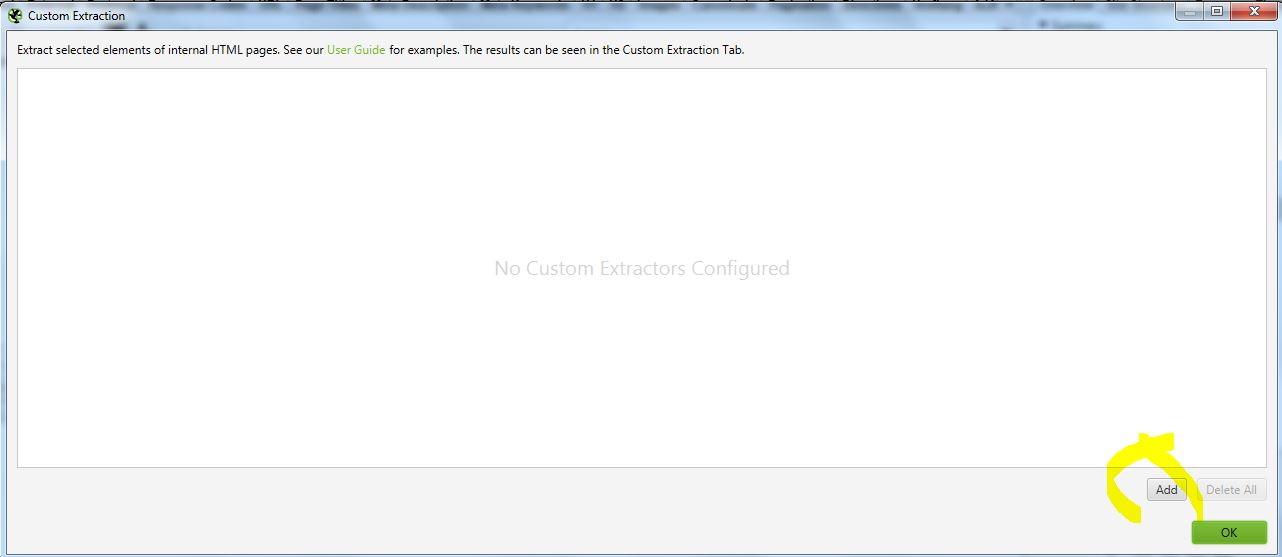

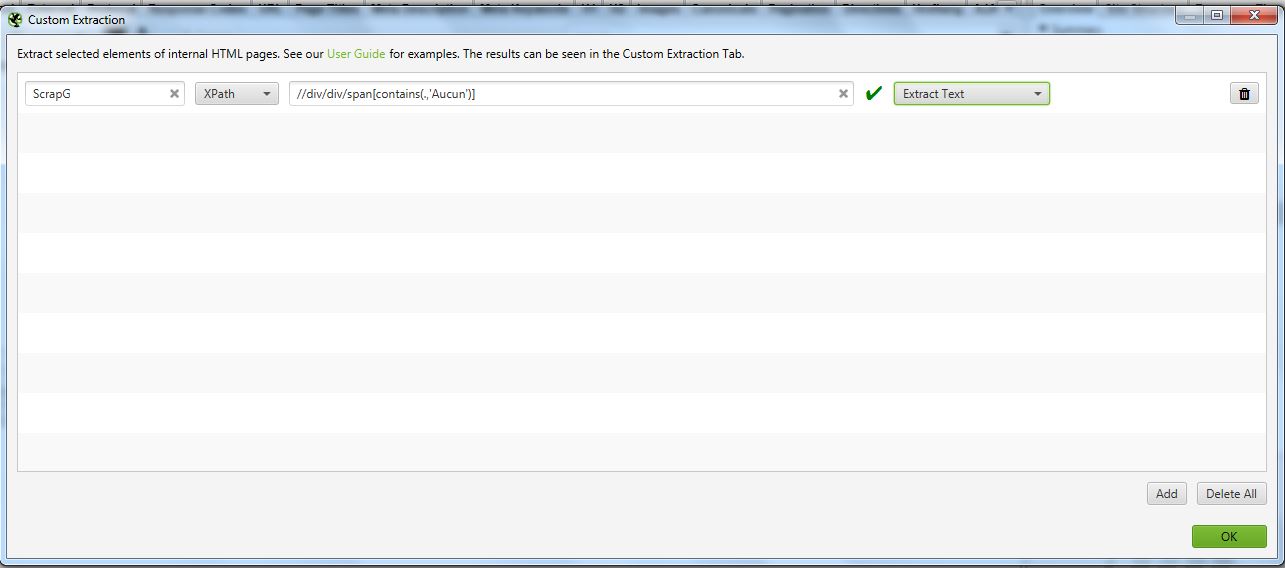

Lancez Screaming Frog et rendez-vous dans configuration > Custom > Extraction puis cliquez sur « Add »

Puis renseignez le paramétrage comme ci-dessous en choisissant Xpath avec le code

//div/div/span[contains(.,’Aucun’)]

et choisissez « Extract texte. »

Passez ensuite Screaming frog en mode > list via le menu puis copiez-collez vos urls créées avec le langage R et disponibles prêtes à l’emploi dans le fichier desindexationsf.csv

Il vous faut cliquer sur Upload > Enter manually pour pouvoir ensuite copier-coller ces urls,

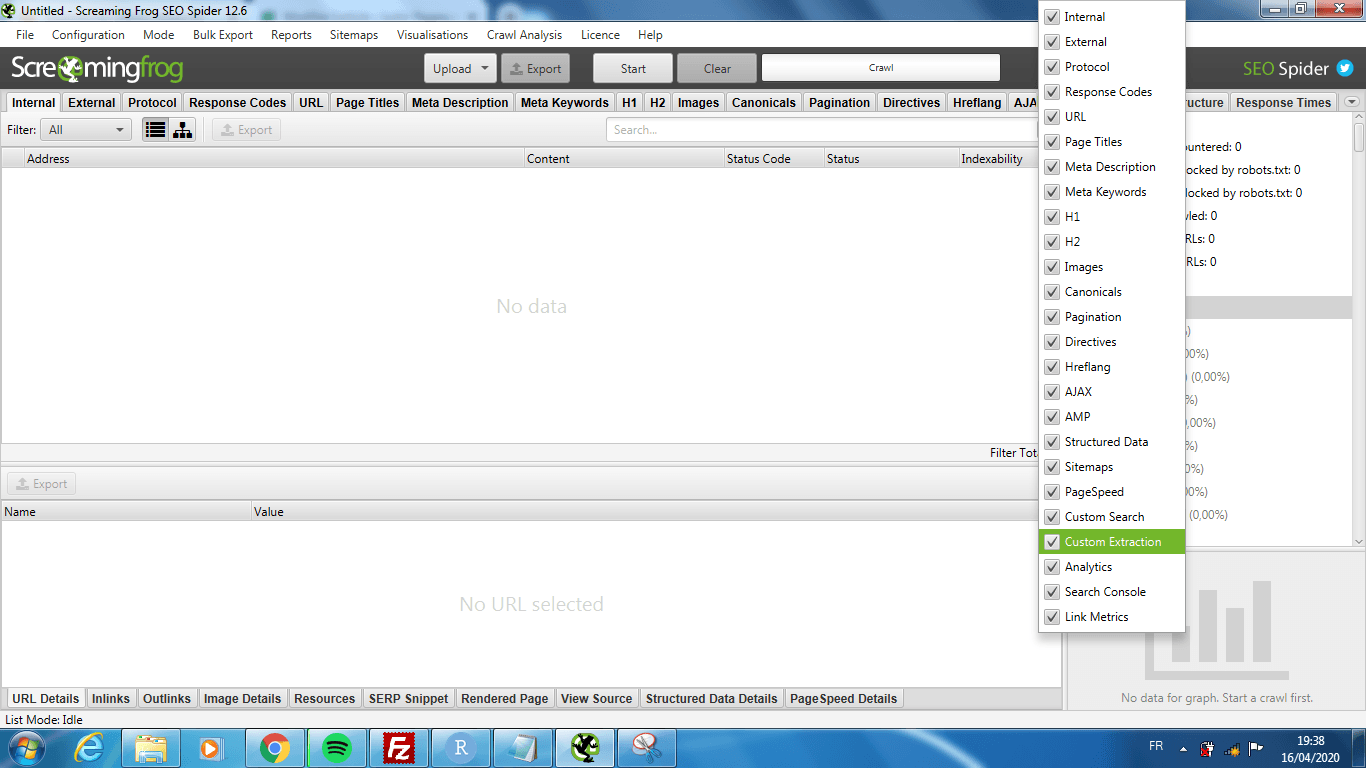

Vos résultats se trouveront dans l’onglet Custom Extraction, pour y avoir accès, il faut cliquer sur la flèche vers le bas située juste après les onglets Hreflang et AJAX.

En ce qui concerne l’interprétation des résultats, si vous constatez la mention « Aucun document ne correspond aux termes de recherche » cela signifie que l’url a bien été désindexée par google 😉 et vous pouvez la désactiver de votre site sans crainte 🙂